连上的人越多,,对方请求尝试的区块同时访问数量也越大,因为对方请求的区块是随机的,等于说任务文件大小=内存缓存,,这才是合理的,

如果内存不够多,就会大幅度走磁盘去取了,

除非,可以像超级种子那样,增强下在内存用尽的时候自动通知对方下载用户当前种子中已有的区块,而不去请求其他的区块数据。。这样的话IO可以降下来,反之带来的就是做种任务会上传速度大幅度降低,因为对方拿不到想要的区块数据,因为内存用尽导致的范围响应,打个比方就是1000个区块,只响应第300-600这300个(自身响应给对方的数据可能对方已经有了)

所以,,我说的这种降低IO的范围响应区块,,也不推荐做这种功能。。。

這個估計是大種子的死症…得從算法改起…

不然一個塊16MB32MB…但你卻只用256KB就沒啥意思了…

好多數據都丟棄了…浪費硬盤性能

目前大種子下完基本上直接關閉了…硬盤杠不住

也懶得換其他客戶端…

其他客户的有一样的磁盘性能问题,但是其他客户的没有申请进程内存,走的是系统内存,

任务管理器里面就看不到内存占用了,但是实际上还是占用的,其实进程申请内存比系统内存更可靠,因为可常驻进行进程调度优化

我只想问一句 什么时候能够整个合理的web界面 最好支持远程下载 蛮重要的

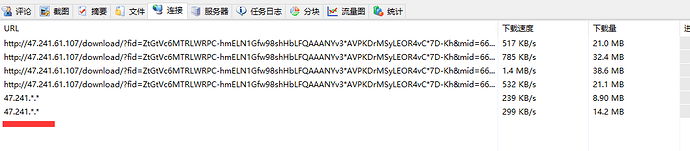

http添加镜像地址的时候,每行一个,,能不能复制的多行相同的链接不要算一个?这样可以对镜像链接启用多线程下载

话说添加的镜像链接,,,显示变成缩写ip了,,不是url了,况且停止的时候可以看到ip,一旦任务开始就看不到了。。。

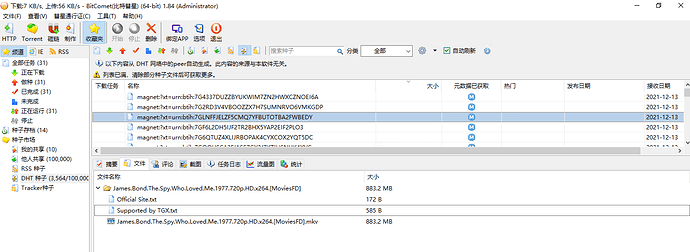

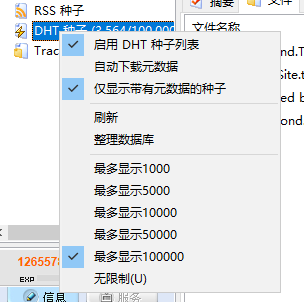

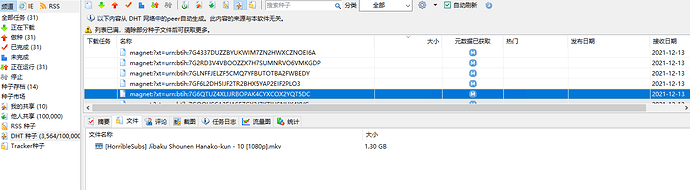

dht获取到的数据不包含文件名跟大小,除非下载元数据不然是看不到的

搜索这里能支持更多规则吗?

现在只支持单关键词搜索以及and 能不能支持其他的比如

或 关键词1 or 关键词2

排除 关键词1 -关键词2

以及更高级一点

关键词1 (关键词2 or 关键词3) -关键词4

这种

另外的比如通配符* ?这种

以及对大小的过滤 {{size}}>100M 大小大于100M {{size}}<10G 这种

对于时间的过滤 添加时间 发布时间 added_time>2020-01-01 createtime>2020-01-01

图上显示了已经获取元数据,包含下方选项卡中可以获取到文件名

wss解析peer字段的问题还没修复吗,,,永远返回0peer

超时也还没搞好,,,老是卡着

是最新的1.85 beta1版本吗?这一版修复了一个缓存达到上限时磁盘读取上传数据的bug

目前是尽量使用到设置的缓存上限大小

排在后面了

个别情况下下载到的元数据解析后没有同步刷新种子列表

可以考虑

是简体中文版的状况吧?

可以考虑

WSS返回的peer使用webrtc协议,彗星目前还不支持

嗯,,比如说复制五次,就算5个多线程镜像链接,现在知道一种办法就是对每个镜像后面额外增加一个&

这样可以统计为多个。

繁体中文,重命名方式改了mo语言为中文,可以正常用种子市场等

好吧,,原来还不支持,,我就说wss一直有毛病不见修复,两台比特彗星用同一个wss,获取不到对方的ip,原来是不支持

能不能和迅雷一样 用磁力链接添加任务时自动粘贴到框里 每次都右键再粘贴麻烦

没下载到元数据时不能更改下载的文件夹这个能不能改改

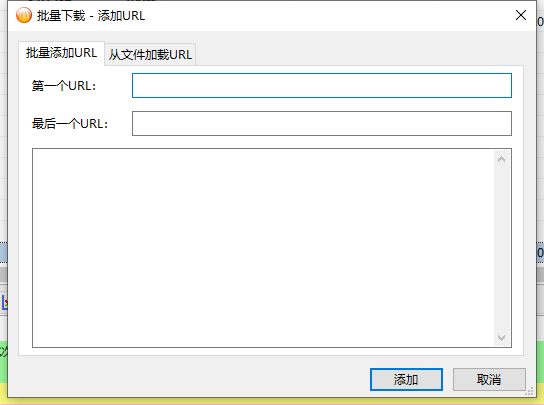

批量添加的下载暂停就变成0%进度了好像。。。而且视乎无法启用多线程?